Appleユーザーから、iOS 17.4.1でiPhoneが再起動を繰り返す問題が発生しているとの報告がありました。対処方法については、こちらのガイドをご覧ください。

Appleはオーストラリアで、未成年ユーザーがヌードを含む写真や動画をAppleに直接報告できる新しい子ども向け安全機能をテストしています。AppleはiOS 18.2で拡張されたコミュニケーションセーフティ機能をテストしており、まもなく全世界でリリースされる予定です。

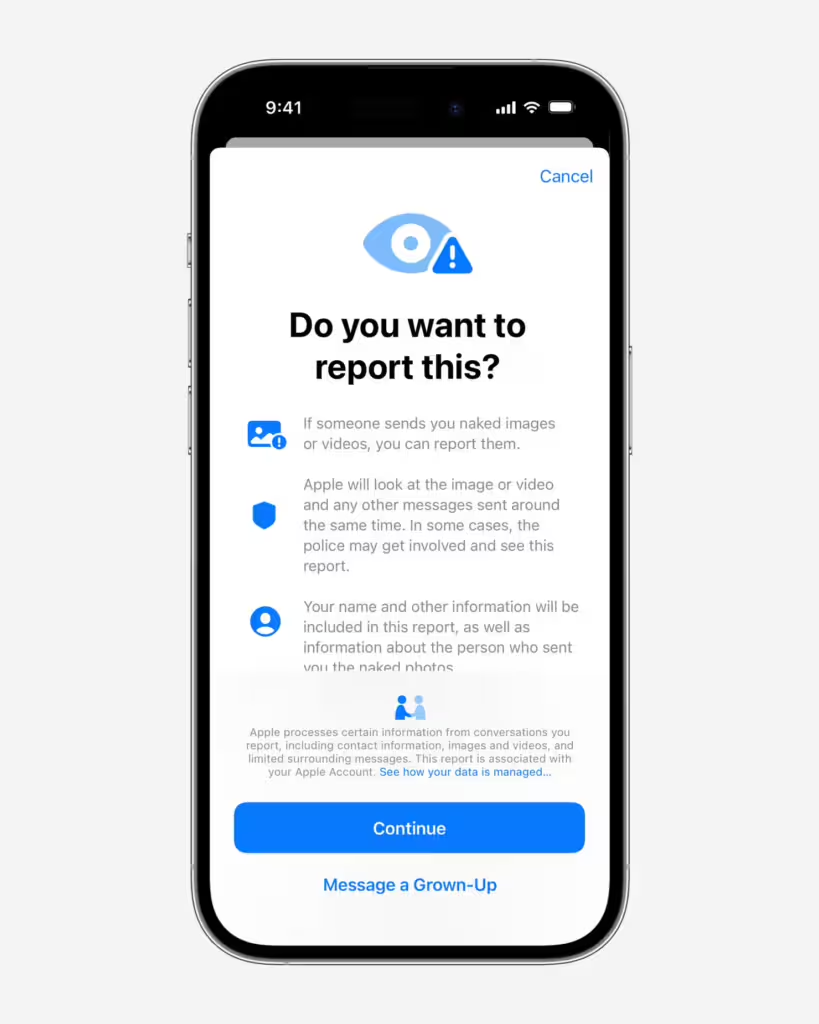

既存のコミュニケーションセーフティ機能は、デバイス上のスキャン機能を使用して、メッセージ、AirDrop、コンタクトポスターなどのAppleサービスを通じて受信した不適切なコンテンツを検出し、ぼかし処理を行います。新機能では、ユーザーが画像や動画に関する報告をAppleに送信できるようになります。

ガーディアン紙によると、これらの報告には、フラグが付けられたコンテンツ、関連するメッセージ、双方の連絡先情報、そしてユーザーがインシデントの詳細を記入する任意フォームが含まれるとのことです。Appleはこれらの報告を確認し、iMessageの利用制限から法執行機関への通報まで、様々な措置を講じる可能性があります。

The Verge によると、この展開は、テキスト メッセージのデバイス内スキャンやオプションの機密コンテンツ警告機能など、Android 向けの同様の機能に関する Google の最近の発表に続くものである。

この戦略は、Appleが2021年にiCloud写真から児童性的虐待関連資料をスキャンする計画とは異なる。この計画はプライバシーへの懸念から2022年12月に中止された。

Appleは、この機能のグローバル展開の具体的なスケジュールをまだ明らかにしていない。同社はこの件に関するコメント要請にすぐには応じなかった。